Animatediff V3 及SparseCtrl发布

上周五Animatediff发布了 V3 模型我也做了一些测试,总体来看效果是好了一些,不过没有特别大的变化,感兴趣的可以看我这两个测试视频。测试1️⃣ 测试2️⃣

这次除了V3 模型之外作者还更新了一个Domain Adapter Lora 模型,今天看作者增加了这个模型的介绍。Domain Adapter 是一个基于培训视频数据集中静态帧进行训练的 LoRA 模块。在推理时,通过调整 Domain Adapter 的 LoRA 尺度,可以消除一些培训视频中的视觉特征(例如水印)。

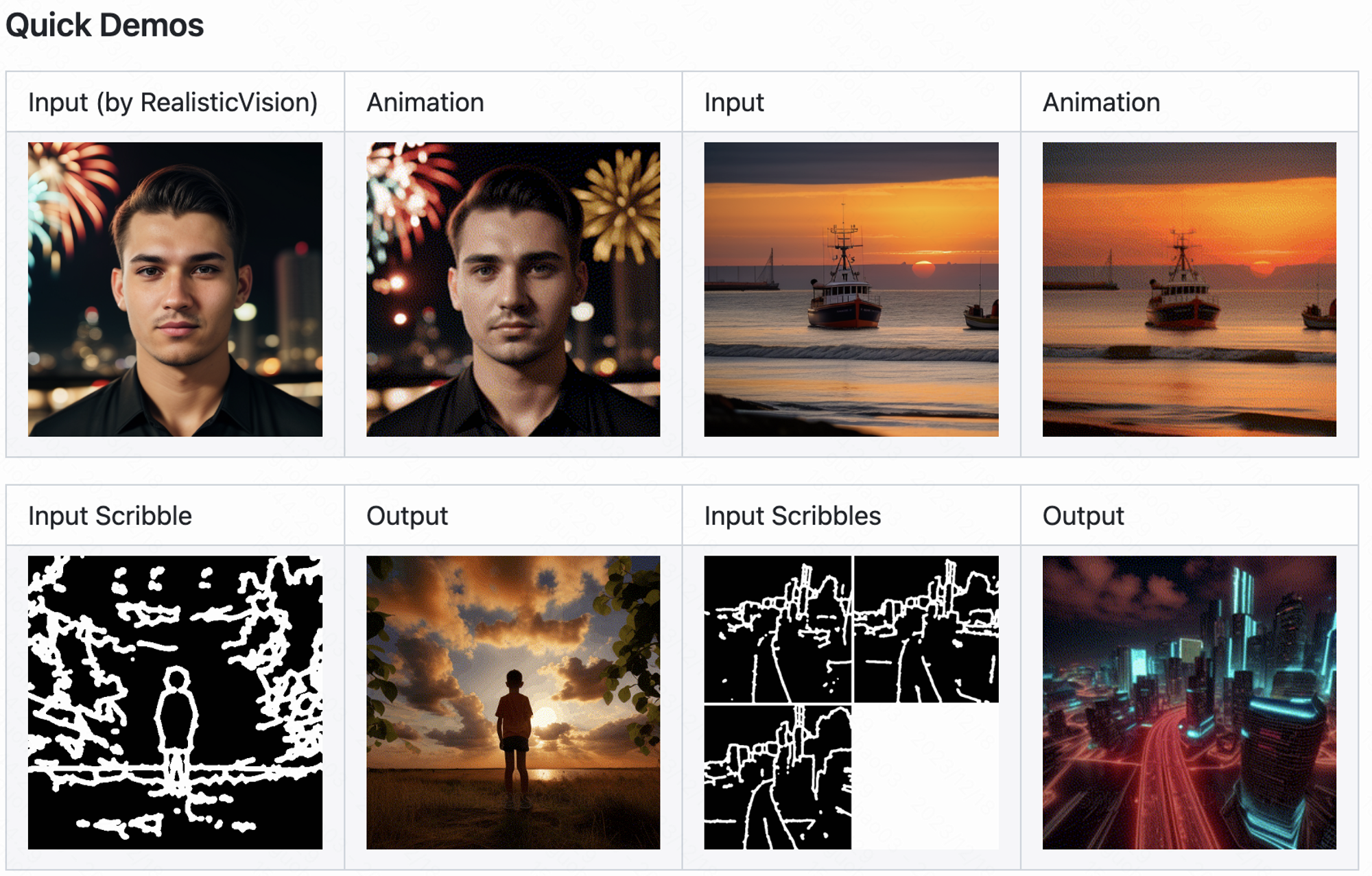

除了Domain Adapter Lora还有之前作者提的视频控制模型,可以理解为视频生成的 Comtorlnet SparseCtrl也发布了,这个模型可以实现输入图像生成视频,也可以只用输入图像中的某一个部分比如深度图或者线稿。

SparseCtrl具体支持的能力包括让单张图像动起来,或者讲两张图片当成关键帧插值,视频插帧功能,输入初始视频帧对视频后续内容进行预测,深度图转视频,草图转视频。

这次SparseCtrl发布了草图和深度的两个控制模型,不过使用需要 ComfyUI 和 Web UI 插件进行适配插件作者说已经在做了。

© 版权声明

文章版权归作者所有,未经允许请勿转载。