Grok 模型的基本信息

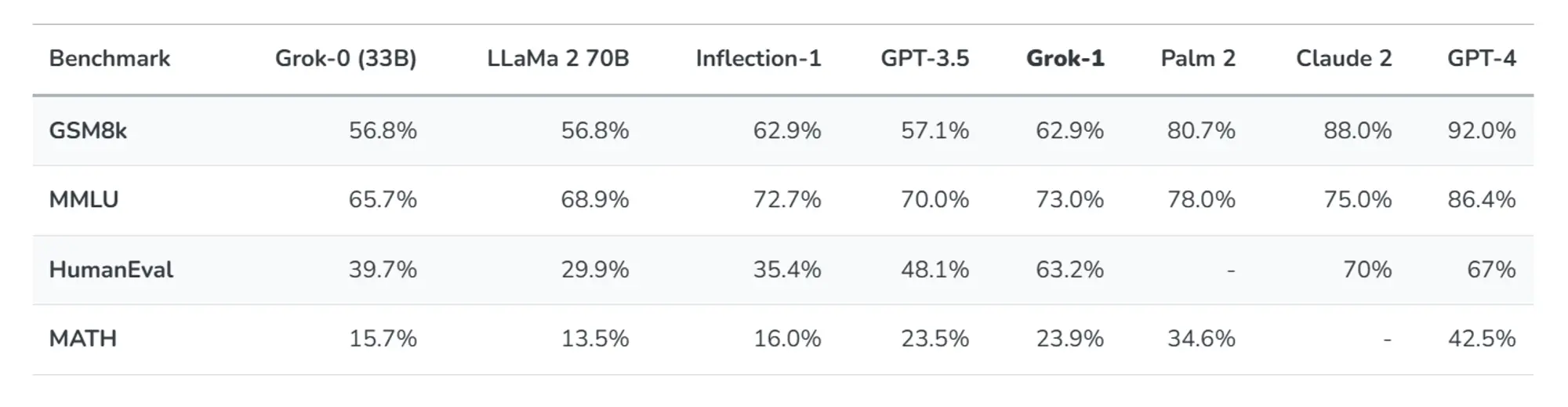

在宣布xAI之后,他们训练了一个拥有33B参数的原型LLM(Grok-0)。这个早期模型在标准的语言模型基准测试中接近LLaMA 2(70B)的能力,但只使用了一半的训练资源。

在过去的两个月中,他们在推理和编码能力方面取得了显著的改进,最终开发出了Grok-1,这是一款先进的语言模型,具有更强大的性能,人工评估编码任务得分达到63.2%,MMLU得分达到73%。

在这些基准测试中,Grok-1展现出了强大的结果,超过了其所属计算级别中的所有其他模型,包括ChatGPT-3.5和Inflection-1。它只被那些使用了大量训练数据和计算资源进行训练的模型所超越,比如GPT-4。

由于这些基准测试可以在网络上找到,他们不能排除我们的模型无意中是在这些基准测试上进行训练的,因此他们对模型(以及Claude-2和GPT-4)在2023年5月底发布的匈牙利国家高中数学期末考试中进行了手动评分,这是在我们收集数据集之后发布的。Grok以C(59%)的成绩通过了考试,而Claude-2获得了相同的成绩(55%),GPT-4以68%的成绩获得了B。

所有模型都在温度为0.1且相同的提示下进行评估。必须注意的是,他们没有为此评估进行任何调整。这个实验作为对我们的模型从未明确调整过的数据集进行的“现实生活”测试。

从上面这段描述来看老马的团队还是要脸的,比国内一些用测试题训练做开卷考试,完事还厚颜无耻的说超过GPT-4的强很多。

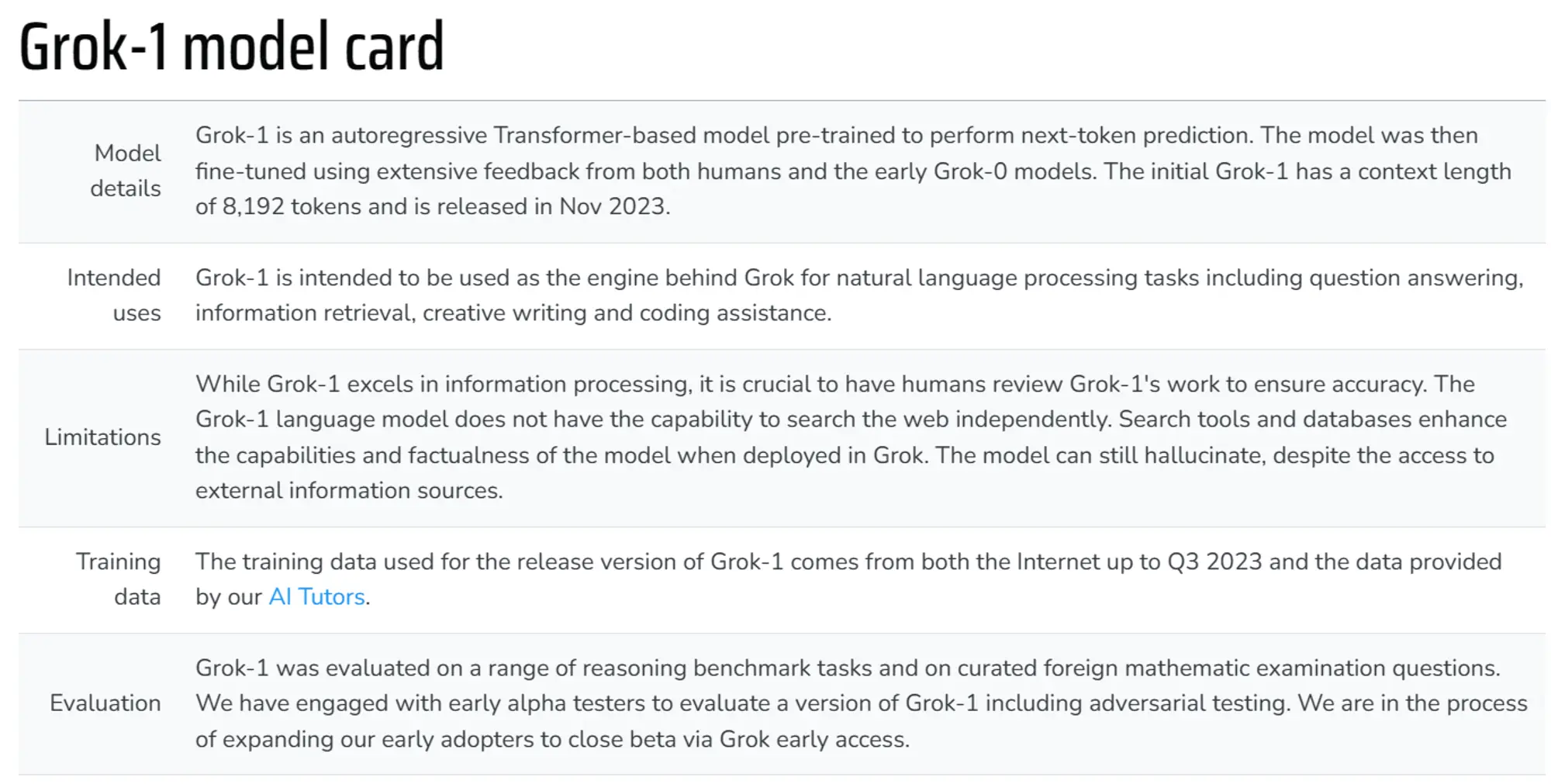

同时根据模型卡的介绍初始的Grok-1具有8,192个Token的上下文长度,Grok-1发布版本所使用的训练数据来自互联网截至2023年第三季度的数据以及我们的AI导师提供的数据。

© 版权声明

文章版权归作者所有,未经允许请勿转载。