如果您有兴趣尝试以不同方式训练的最新 AI 模型和大型语言模型。或者只是想在你的家庭网络上本地运行一个开源AI模型。协助您完成日常任务。您会很高兴地知道,在本地计算机上运行LLM和AI代理非常容易,而无需第三方服务器。显然,您的笔记本电脑或台式计算机功能越强大越好,但只要您至少有 8GB 的 RAM,您应该能够运行至少一两个较小的 AI 模型,例如 Mistral 等。

在本地运行 AI 模型为个人和小型企业提供了使用 AI 进行试验和创新的机会,而无需昂贵的服务器或基于云的解决方案。无论您是学生、AI 爱好者还是专业研究人员,您现在都可以轻松地在 PC、Mac 或 Linux 机器上运行 AI 模型。

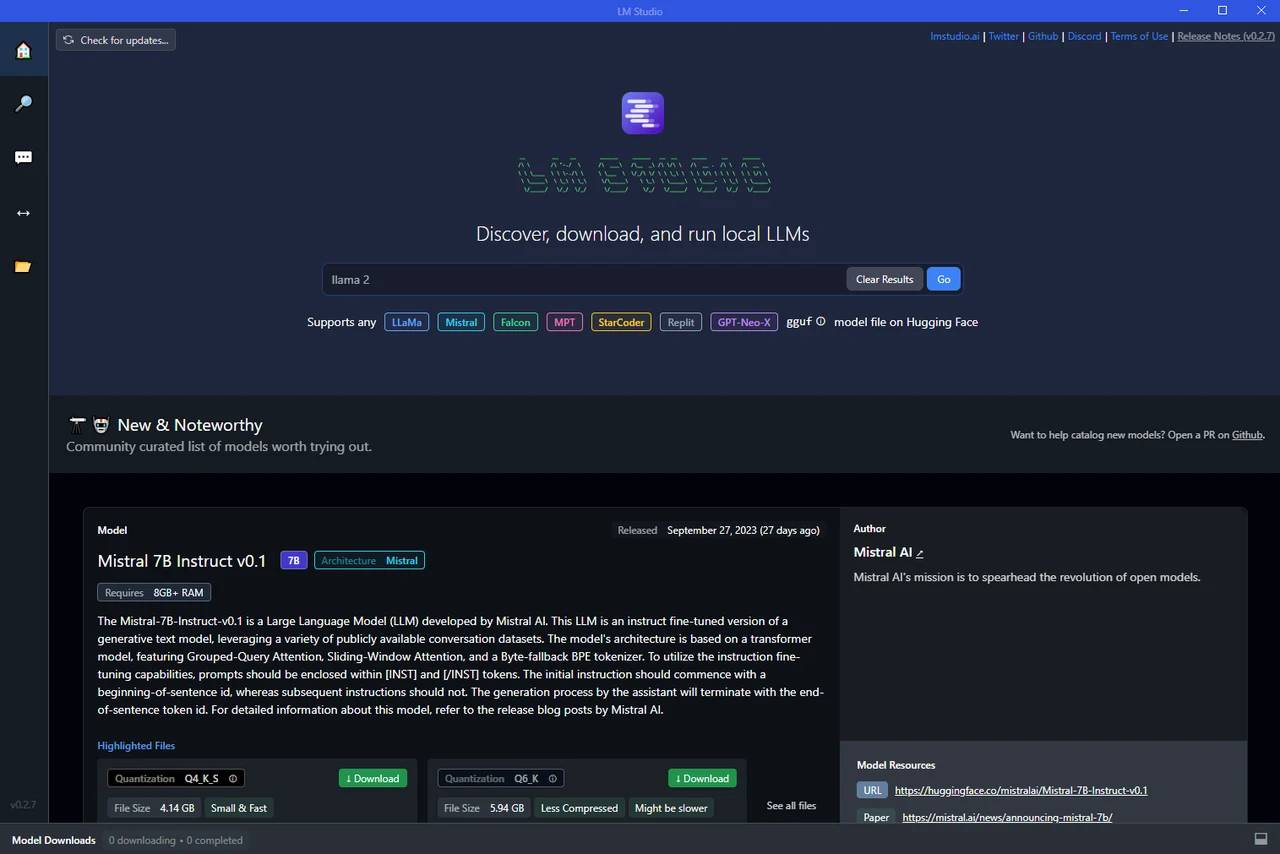

用于此目的的最用户友好的工具之一是LM Studio,该软件可让您安装和使用各种AI模型。通过简单的安装过程,您可以立即在计算机上设置 LM Studio。它支持广泛的操作系统,包括Windows,macOS和Linux,使广泛的用户可以访问它。

LM Studio 的用户界面专为初学者和高级用户而设计。高级功能被整齐地隐藏起来,因此它们不会让新用户不知所措,但需要它们的人可以轻松访问。例如,您可以自定义选项和预设以根据您的特定需求定制软件。

LM 工作室仪表板

LM Studio 支持多种 AI 模型,包括大型语言模型。它甚至允许以 GF 格式运行量化模型,从而提供了一种在计算机上运行这些模型的更有效方法。下载和添加不同型号的灵活性是另一个关键功能。无论您是对 NLP、图像识别还是任何其他 AI 应用程序感兴趣,您都可以找到适合您需求的模型。

搜索 AI 模型和 LLM

需要 AVX2 支持

您的计算机需要支持 AVX2,这里有几种方法可以检查正在运行的 CPU 或系统。知道后,您可以进行快速搜索,以查看规格列表是否支持 AVX2。一旦你知道你的CPU,你也可以问ChatGPT。显然,OpenAI截止日期之后的CPU最有可能支持AVX2。

窗户:

- 打开命令提示符。

- 运行命令 。

systeminfo - 在显示的信息中查找您的 CPU 型号,然后在线搜索该特定 CPU 型号以查找其规格。

macOS:

- 转到苹果菜单 – >关于本机 – >系统报告。

- 在“硬件”下,找到“内核总数”和“处理器名称”。

- 在线搜索该特定 CPU 型号以检查其规格。

Linux:

- 打开终端。

- 运行命令或 。

lscpucat /proc/cpuinfo - 检查输出中的标志。

avx2

软件实用程序:

您可以使用 CPU-Z (Windows) 或 iStat Menus (macOS) 等第三方软件来查看 CPU 的详细规格,包括 AVX2 支持。

供应商网站:

访问 CPU 制造商的网站并查找您的 CPU 型号。详细规范应列出支持的指令集。

直接硬件检查:

如果您具备这样做的技能和舒适度,则可以直接检查CPU的标记,然后参考供应商规格。

对于拥有 M2 驱动器的 Windows 用户,LM Studio 可以在此高速存储设备上运行,从而提供增强的性能。但是,如前所述,无论您的操作系统如何,要考虑的一个关键因素是 RAM 要求。根据经验,建议至少使用 8 GB 的 RAM 来运行较小的 AI 模型,例如 Mistral。较大的型号可能需要更多内存,因此请务必检查您有兴趣使用的型号的规格。

在模型配置和推理参数方面,LM Studio 提供了一系列选项。您可以调整这些设置以优化模型的性能,具体取决于您的特定用例。这种级别的控制使您可以充分利用AI模型,即使在个人计算机上运行它们也是如此。

LM Studio 最强大的功能之一是能够创建本地主机并通过 API 为您的模型提供服务。这意味着您可以将模型集成到其他应用程序或服务中,从而提供一种操作 AI 模型的方法。此功能将 LM Studio 从单纯的本地运行 AI 模型的工具转变为构建和部署 AI 驱动的应用程序的平台。

现在,在 PC、Mac 或 Linux 机器上本地运行 AI 模型比以往任何时候都更容易。使用 LM Studio 等工具,您可以试验不同的模型、自定义设置,甚至通过 API 提供模型。无论您是初学者还是经验丰富的 AI 专业人士,这些功能都为人工智能领域的创新和探索开辟了一个充满可能性的世界。