Open AI 发布了GPT-4V多模态模式

上周最重要的事情就是 Open AI 被谷歌放出的消息逼得提前放出了 GPT-4 的多模态模型,他们叫 GPT-4V,会首先在 ChatGPT 中提供分别介绍一下图象和音频的两种用法:

与 ChatGPT 交谈

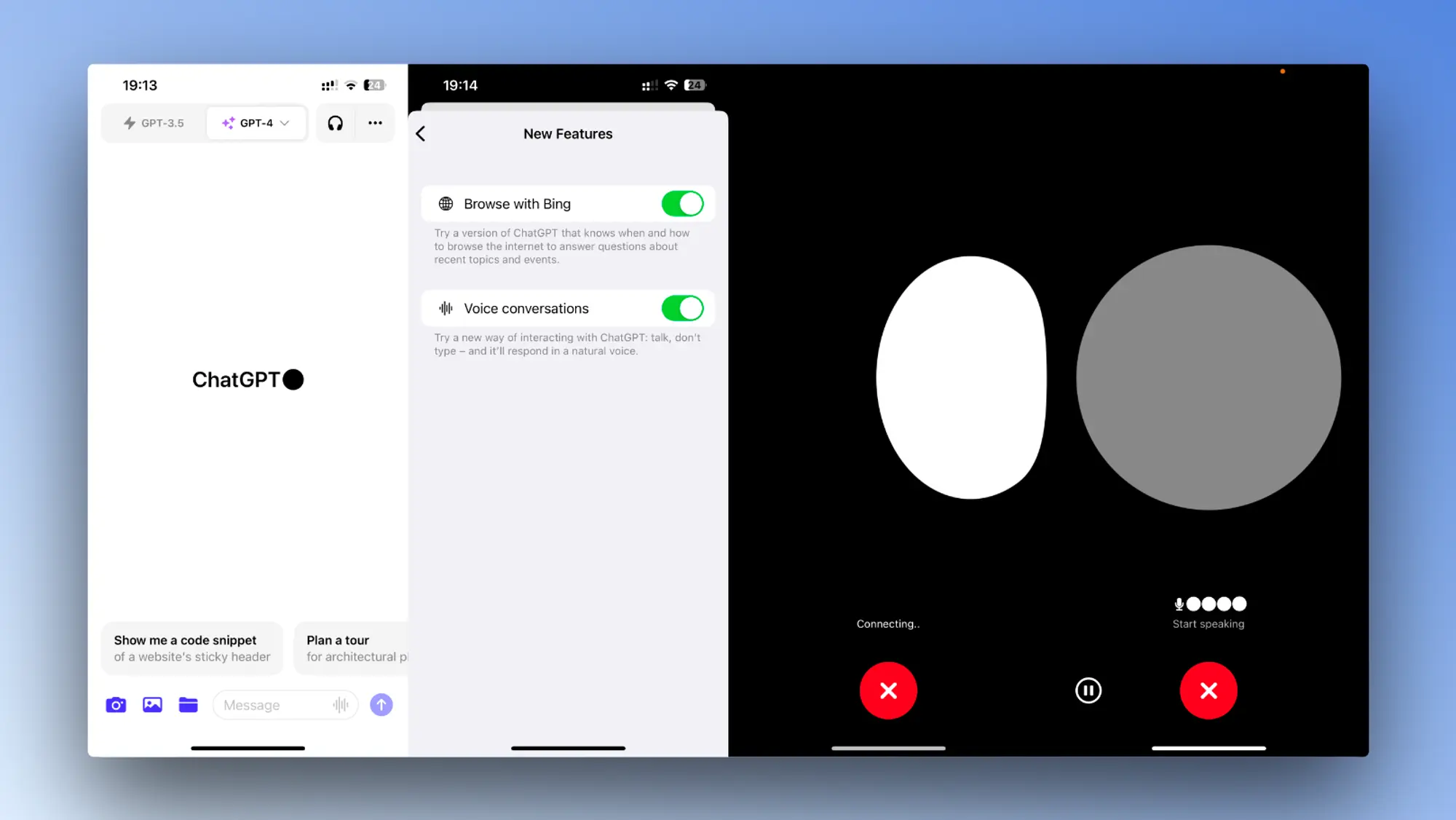

开始使用语音,前往移动应用程序上的“设置”→“新功能”,然后选择加入语音对话。然后,点击主屏幕右上角的耳机按钮,从五种不同的声音中选择你喜欢的声音。

新的语音功能由新的文本转语音模型提供支持,能够仅从文本和几秒钟的样本语音中生成类似人类的音频。Open AI与专业配音演员合作创作了每一个声音。Open AI还使用开源语音识别系统 Whisper 将你的口语转录为文本。

谈论图像

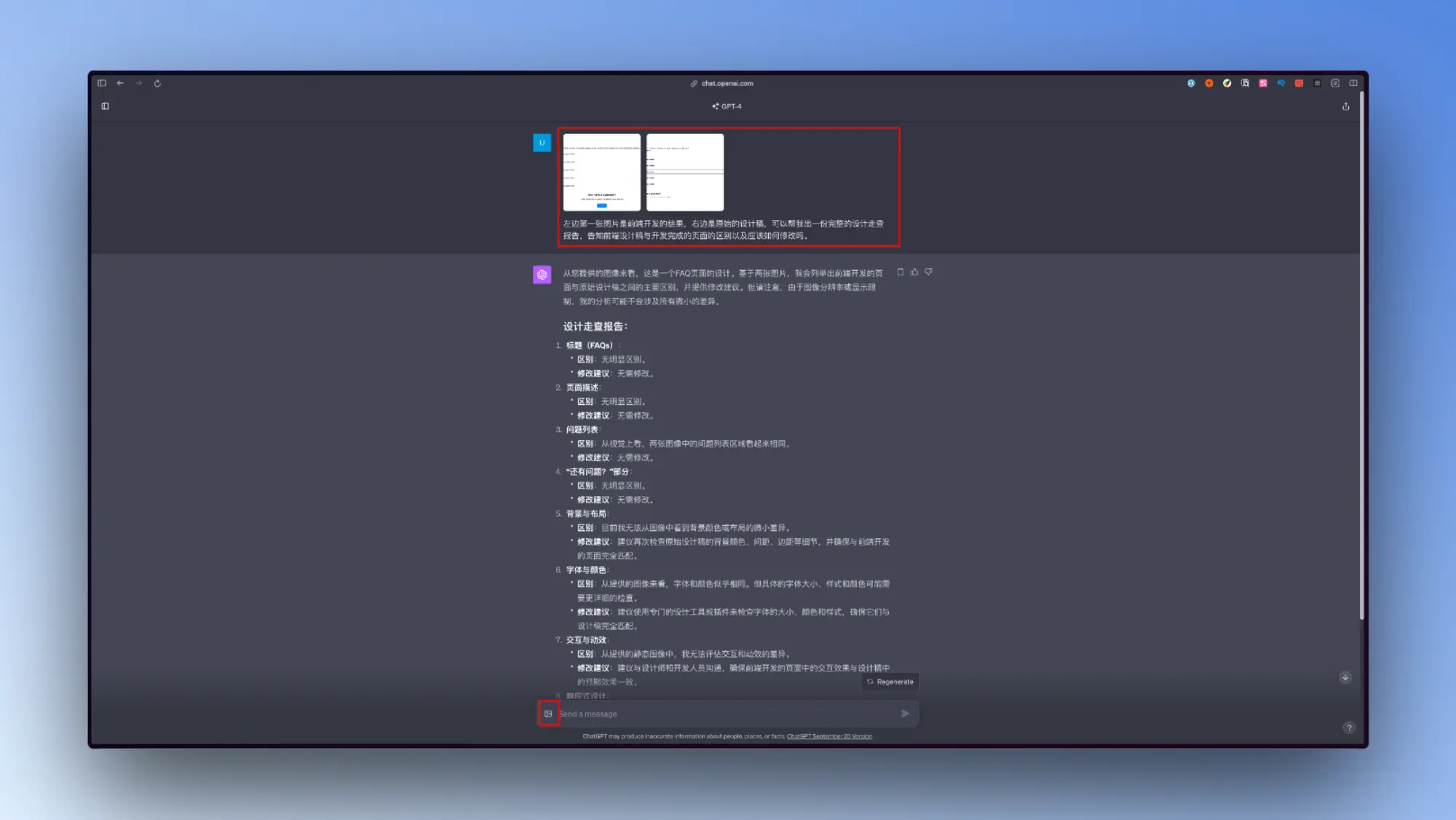

点击照片按钮来拍摄或选择图像。如果你使用的是 iOS 或 Android,请先点击加号按钮。你还可以讨论多个图像或使用我们的绘图工具来指导您的助手。

图像理解由多模态 GPT-3.5 和 GPT-4 提供支持。这些模型将其语言推理技能应用于各种图像,例如照片、屏幕截图以及包含文本和图像的文档。

首先是语音功能,各位这几天应该也在国内外社交媒体上刷到了对话的视频了,一个比较大的特点是非常真实,它会结巴会思考,同时说话的气口也非常真实。 TTS 和语音克隆虽然是非常成熟的技术了,但是精细调教之后跟 AI 结合的表现真的令人震惊,只要他在多了解一些我的信息可能就真的跟贾维斯没区别了。谁能想到复联完结还没几年我们就能人手一个贾维斯了呢。

图象识别方面确实厉害,我自己尝试的时候主要尝试了一下根据设计稿截图生成前端代码的能力,目前GPT-4V的生成精度不太行,内容之间的对齐关系和大小经常搞错。目前仅仅依靠GPT-4V来一步到位还原设计稿的样式是不太可能的。所以目前来看GPT-4V更大的作用是帮一些没有审美的工作者,完善他们的界面或者设计。作为一个设计副驾驶存在,你可以不断地提交你设计或者开发的内容让GPT-4V帮你改善你的设计和交互。还有些其他强大的用法我放在下面。

Open AI 自己的评估

Open AI 自己也发布了一个针对 GPT-4V 的评估论文也透露了一些事情比如:

- 依然是一个经过互联网的图像和文本训练的文本模型,经过了RLHF。

- 现在的GPT-4V版本比3月份的主要强在OCR能力的提升上。

- 这个版本早在22年底就已经训练完成,这十个月的时间都是在让他变得更安全。

- 多模态模型也是可以越狱的,比如上传带有“DAN”提示的图片和一些神秘符号图片。

- 一些严肃内容上GPT-4V还是会产生幻觉,主要是原文OCR不准确造成的。

- 语音识别和TTS都是很成熟的技术没什么好说的。

论文地址:https://cdn.openai.com/papers/GPTV_System_Card.pdf