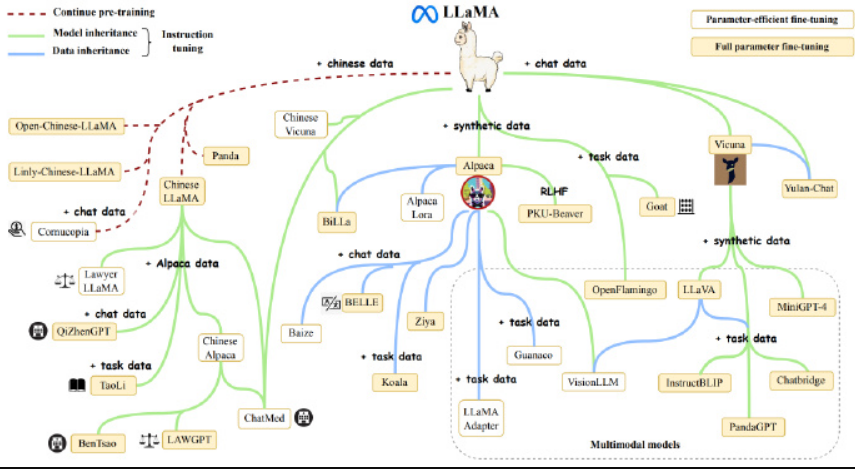

ChatGPT 引发的大模型热潮愈演愈烈,全球科技巨头和明星初创争相入局,打造以 AI 大模型为核心的竞争力和多样化商业使用需求。 LLaMA 系列模型,因良好的基础能力和开放生态,已积累了海量的用户和实际应用案例,成为无数开源模型后来者的模仿和竞争的标杆对象。

如何降低类 LLaMA2 大模型预训练成本,如何基于 LLaMA2 通过继续预训练和微调,低成本构建 AI 大模型实际应用,仍是 AIGC 相关企业面临的关键瓶颈。

作为全球规模最大、最活跃的大模型开发工具与开源社区,Colossal-AI 再次迭代,提供开箱即用的 8 到 512 卡 LLaMA2 训练、微调、推理方案,对 700 亿参数训练加速 195%,并提供一站式云平台解决方案,极大降低大模型开发和落地应用成本。

开源地址:github.com/hpcaitech/ColossalAI

此外,为了进一步提升开发和部署效率,技术团队还将上述系统优势与算力结合,提供 Colossal-AI 云平台,提供廉价算力和开箱即用的 AI 主流应用,包括对话大模型,多模态模型,生物医药等。

用户只需要上传相关数据,即可无代码训练个性化私有模型,并将训练好的模型一键部署,非常方便,大家可以试玩一下。

Colossal-AI 云平台:platform.luchentech.com

© 版权声明

文章版权归作者所有,未经允许请勿转载。