继Stability AI的开发团队宣布推出其新的AI声音发生器之后,该声音发生器恰如其分地命名为Stable Audio。本快速概述指南将更深入地探讨用于训练 AI 声音生成网站的技术和数据集,该网站不仅可以在几秒钟内创建声音效果,还可以创建音乐。

在人工智能技术中,基于扩散的生成模型在提高生成的图像、视频和音频的质量和可控性方面取得了重大进展。这些模型,特别是潜在扩散模型,在预训练的自动编码器的潜在编码空间中运行,在扩散模型的训练和推理中提供了实质性的速度改进。但是,使用扩散模型生成音频的一个常见挑战是固定大小的输出,这在生成不同长度的音频时可能会带来困难。

人工智能声音发生器

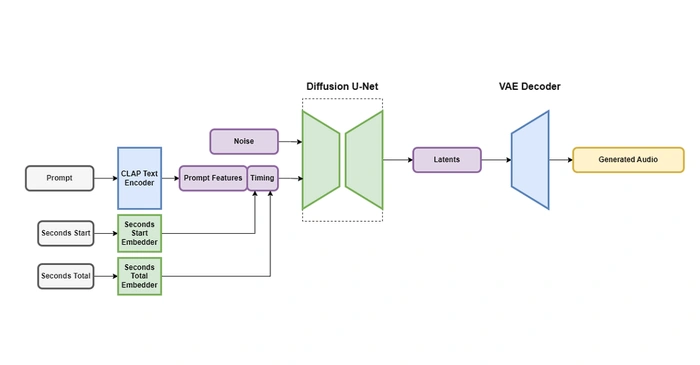

为了解决这个问题,引入了一种新的潜在扩散模型架构,即Stable Audio。这种创新模型以文本元数据、音频文件持续时间和开始时间为条件,提供对生成音频的内容和长度的控制。与其前辈不同,Stable Audio可以生成指定长度的音频,最大可达训练窗口大小,从而克服了固定大小输出的限制。

Stable Audio的主要功能之一是它使用大量下采样的音频潜在表示形式,从而缩短推理时间。该型号能够在不到一秒的时间内在 NVIDIA A95 GPU 上以 44.1 kHz 采样率渲染 100 秒的立体声音频,展示了其令人印象深刻的速度和效率。

稳定性 AI Stable Audio

Stable Audio的架构由变分自动编码器(VAE)、文本编码器和基于U-Net的条件扩散模型组成。VAE在将立体声音频压缩为数据压缩、抗噪声和可逆有损潜在编码方面发挥着至关重要的作用,这有助于更快地生成和训练。该模型以文本提示为条件,使用在数据集上从头开始训练的 CLAP 模型的冻结文本编码器。

Stable Audio的另一个独特功能是在训练期间计算时序嵌入。这允许用户在推理期间指定输出音频的总长度,从而为音频生成提供更大的控制和灵活性。

Stable Audio的扩散模型是基于Moûsai中使用的模型的907M参数U-Net,证明了其强大而复杂的架构。为了训练Stable Audio模型,使用了包含音乐、音效和单乐器词干以及相应文本元数据的超过 800,000 个音频文件的数据集。这个广泛的数据集强调了Stable Audio可以生成的全面而多样化的音频范围。

Stable Audio是Stability AI的生成音频研究实验室Harmonai进行的尖端音频生成研究的产物。该实验室处于人工智能生成音频领域的创新前沿,Stable Audio证明了他们的开创性工作。

展望未来,Harmonai 的未来版本将包括基于Stable Audio的开源模型和用于训练音频生成模型的训练代码。这些即将到来的发展有望进一步推动人工智能生成音频领域的发展,为声音的创建和处理提供新的可能性。

Stable Audio代表了人工智能生成音频领域的重大进步。通过解决固定大小输出的限制,并提供对生成音频的内容和长度的更大控制,Stable Audio正在为更复杂和通用的音频生成模型铺平道路。在官方网站上亲自试用新的AI声音生成器。