ChatGLM2-6B 模型发布

之前效果不错的 ChatGLM模型发布了第二代。他们的6B 可以部署在消费级设备上的。

ChatGLM2-6B 是开源中英双语对话模型 ChatGLM-6B 的第二代版本,在保留了初代模型对话流畅、部署门槛较低等众多优秀特性的基础之上,ChatGLM2-6B 引入了如下新特性:

- 更强大的性能:基于 ChatGLM 初代模型的开发经验,全面升级了 ChatGLM2-6B 的基座模型。

- 更长的上下文:将基座模型的上下文长度(Context Length)由 ChatGLM-6B 的 2K 扩展到了 32K,并在对话阶段使用 8K 的上下文长度训练,允许更多轮次的对话。

- 更高效的推理:基于 Multi-Query Attention 技术,ChatGLM2-6B 有更高效的推理速度和更低的显存占用:在官方的模型实现下,推理速度相比初代提升了 42%,INT4 量化下,6G 显存支持的对话长度由 1K 提升到了 8K。

- 更开放的协议:ChatGLM2-6B 权重对学术研究完全开放,在获得官方的书面许可后,亦允许商业使用。

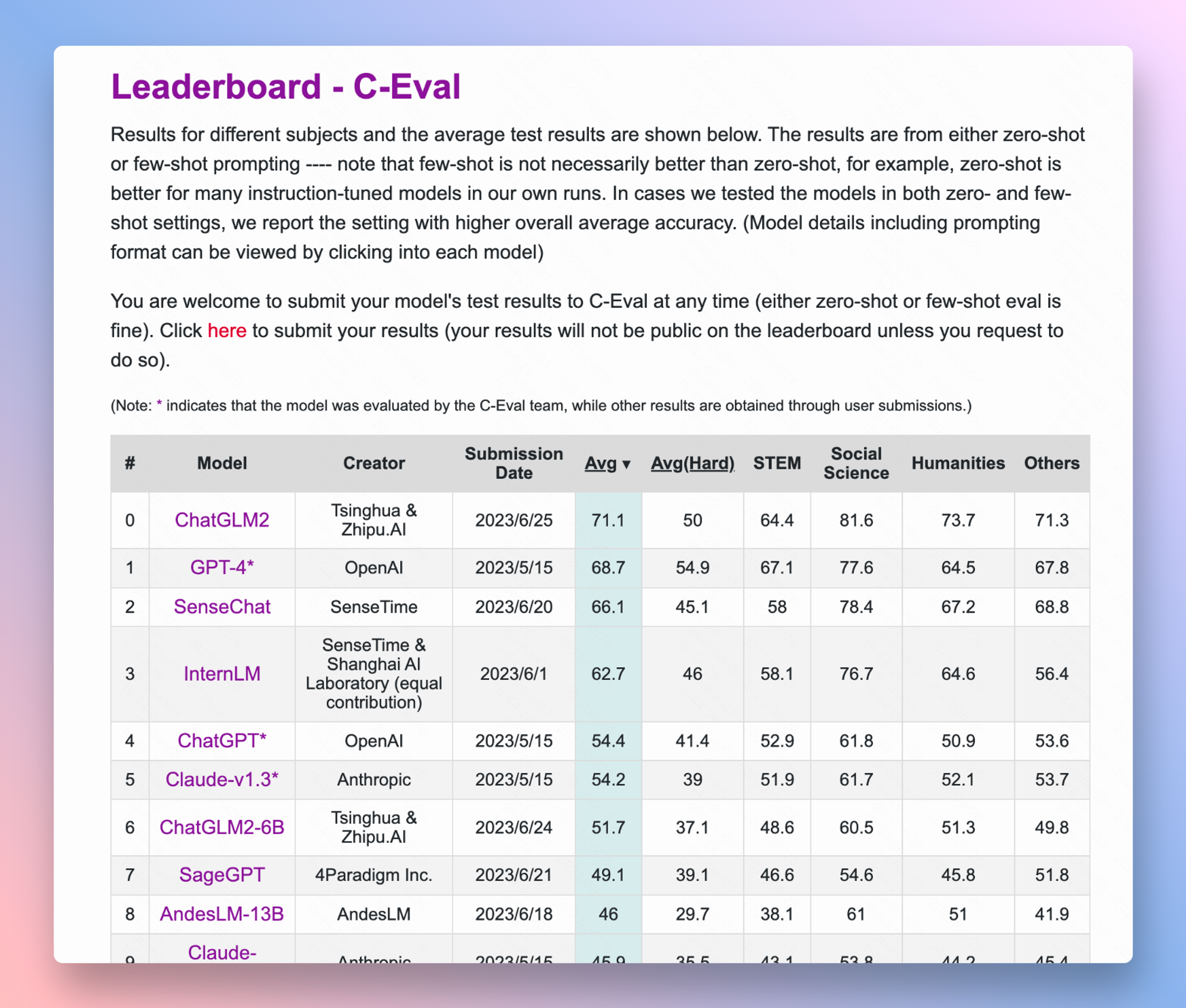

更离谱的是 ChatGLM2-6B 在Leaderboard – C-Eval这个测试的评分居然超过了 GPT-4 。九原客推测可能是因为国内经常用c-eval和gaokao这两个数据集测评大模型,其实这些测试集都是单项选择题,所以即使是蒙都能蒙 25 分,而且有可能测试数据集在训练的时候就被灌给了模型,相当于开卷考试了才会这样。

© 版权声明

文章版权归作者所有,未经允许请勿转载。