1. 简化 ChatGPT 类型模型的训练和强化推理体验

开发者只需一个脚本,就能实现多个训练步骤,并且在完成后还可以利用推理 API 进行对话式交互测试。

2. DeepSpeed-RLHF 模块

DeepSpeed-RLHF 复刻了 InstructGPT 论文中的训练模式,并提供了数据抽象和混合功能,支持开发者使用多个不同来源的数据源进行训练。

3. DeepSpeed-RLHF 系统

团队将 DeepSpeed 的训练(training engine)和推理能力(inference engine) 整合成了一个统一的混合引擎(DeepSpeed Hybrid Engine or DeepSpeed-HE)中,用于 RLHF 训练。由于,DeepSpeed-HE 能够无缝地在推理和训练模式之间切换,因此可以利用来自 DeepSpeed-Inference 的各种优化。

DeepSpeed-RLHF 系统在大规模训练中具有无与伦比的效率,使复杂的 RLHF 训练变得快速、经济并且易于大规模推广:

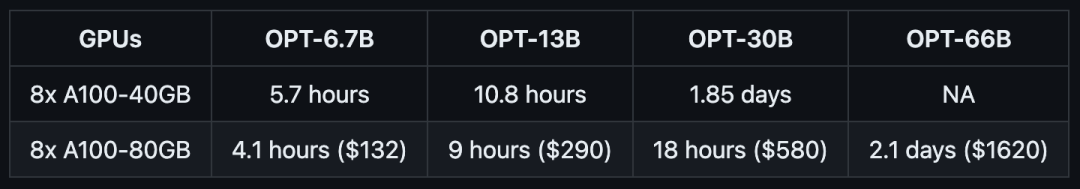

高效且经济:

DeepSpeed-HE 比现有系统快 15 倍以上,使 RLHF 训练快速且经济实惠。

例如,DeepSpeed-HE 在 Azure 云上只需 9 小时即可训练一个 OPT-13B 模型,只需 18 小时即可训练一个 OPT-30B 模型。这两种训练分别花费不到 300 美元和 600 美元。

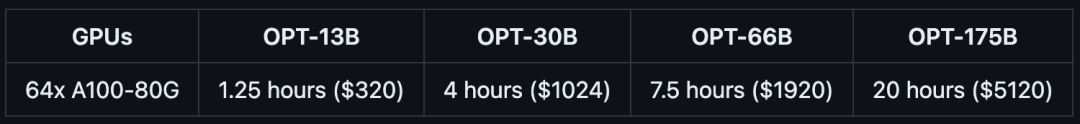

卓越的扩展性:

DeepSpeed-HE 能够支持训练拥有数千亿参数的模型,并在多节点多 GPU 系统上展现出卓越的扩展性。

因此,即使是一个拥有 130 亿参数的模型,也只需 1.25 小时就能完成训练。而对于拥有 1750 亿参数的模型,使用 DeepSpeed-HE 进行训练也只需不到一天的时间。

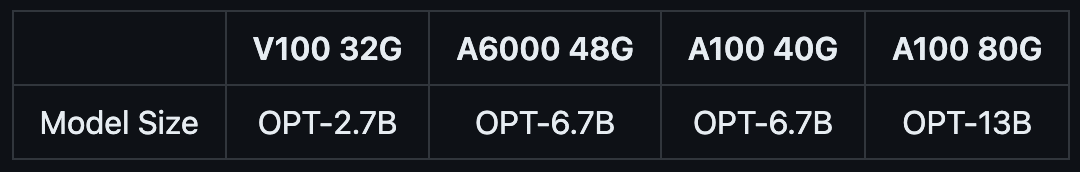

实现 RLHF 训练的普及化:

仅凭单个 GPU,DeepSpeed-HE 就能支持训练超过 130 亿参数的模型。这使得那些无法使用多 GPU 系统的数据科学家和研究者不仅能够轻松创建轻量级的 RLHF 模型,还能创建大型且功能强大的模型,以应对不同的使用场景。